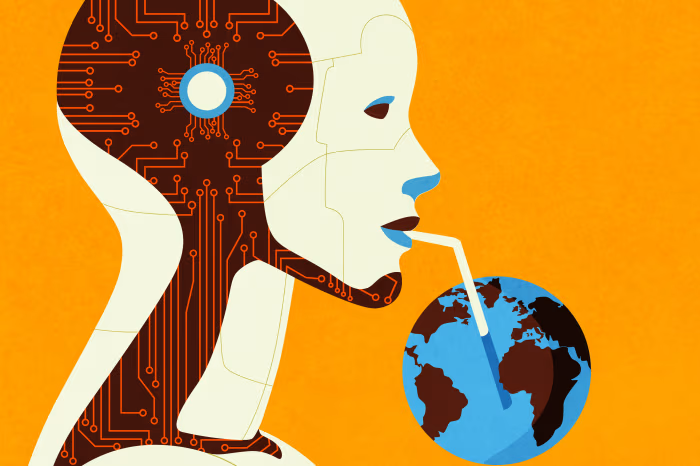

Quando chiedi a LLM come ChatGPT di redigere un’e-mail o Gemini di riassumere un articolo, o DeepSeek di rivedere un documento, stai attingendo alla potenza dei grandi modelli linguistici (LLM). Gli LLM e i sistemi di intelligenza artificiale sono addestrati su enormi quantità di dati di testo per imitare il linguaggio umano. Questi modelli, come GPT-4 di OpenAI, Gemini di Google, DeepSeek-R1 e Llama 2 di Meta, stanno rivoluzionando le industrie, dall’assistenza sanitaria all’istruzione. Ma dietro le loro interfacce eleganti si trova un segreto per la loro insaziabile sete di acqua. Useresti ChatGPT, Gemini, Llama, DeepSeek e altri LLM se sapessi che ogni risposta costa un bicchiere d’acqua?

Il problema non finisce con la formazione. Ogni volta che interagisci con un LLM, consuma acqua. Ad esempio, ogni 10-50 richieste a ChatGPT utilizzano circa 500 millilitri di acqua, a seconda del carico del server. Google Search, che elabora 8,5 miliardi di query al giorno, utilizza 10 volte più acqua se migliorata dall’IA. Anche la posizione gioca un ruolo fondamentale: i data center in regioni calde e secche come l’Arizona o il Cile utilizzano il 40% in più di acqua per il raffreddamento rispetto a quelli in climi più freddi. Il data center di Microsoft in Arizona, ad esempio, utilizza 56 milioni di litri di acqua all’anno abbastanza da sostenere 1.400 famiglie per un anno.

Le conseguenze ambientali e sociali di questo uso dell’acqua sono profonde. Nelle regioni soggette a siccità, i data center competono con l’agricoltura e l’acqua potabile per risorse limitate. In Cile, ad esempio, i data center sono stati accusati di esacerbare la carenza d’acqua per gli agricoltori locali. Nel frattempo, l’energia necessaria per alimentare questi sistemi spesso proviene da impianti di carbone o gas, che a loro volta consumano grandi quantità di acqua per il raffreddamento. Il consumo mensile di energia di ChatGPT consuma indirettamente milioni di litri di acqua attraverso la sola generazione di energia.

Le implicazioni della giustizia sociale sono altrettanto allarmanti. I data center sono spesso costruiti in aree a basso reddito o emarginate, creando “zone di sacrificio” in cui le comunità non hanno le risorse per protestare. Nel “Data Center Alley” dell’Oregon, i residenti hanno sollevato preoccupazioni sugli impatti ambientali e sulla salute delle strutture vicine. A livello globale, l’impronta idrica dell’IA aggrava la disuguaglianza, con regioni colpite dalla siccità nel Sud del mondo che ospitano server per le aziende tecnologiche occidentali. Il Kenya, ad esempio, sta affrontando gravi carenze idriche, ma le sue risorse vengono deviate verso macchine fredde che servono economie lontane.

Nonostante queste sfide, le aziende tecnologiche spesso pubblicizzano il loro impegno per la sostenibilità. Google, ad esempio, afferma che la sua IA è “carbon neutral”, ma dice poco sul suo utilizzo dell’acqua. Questa ipocrisia sottolinea la necessità di una maggiore responsabilità. La crisi idrica non sarà risolta dagli algoritmi, richiede un’azione umana. I giganti della tecnologia devono dare la priorità alle pratiche sostenibili, come il trasferimento dei data center in climi più freddi, gli investimenti in sistemi raffreddati ad aria e il riciclaggio delle acque reflue. I governi devono regolare l’impronta ambientale dell’IA con la tregola tregolare della sua etica. E come utenti, dobbiamo chiederci: abbiamo bisogno di un’altra poesia generata dall’IA se significa che un bambino ha sete?

Gli LLM stanno rimodellando il nostro mondo, ma i loro costi idrici nascosti minacciano di prosciugare il nostro futuro. Non possiamo lasciare che la corsa della Silicon Valley per un’IA più intelligente superi la capacità del nostro pianeta di sopravvivere. La crisi idrica è una crisi umana e richiede soluzioni umane. Mentre ci meravigliamo delle capacità dell’IA, non dimentichiamo il costo reale della sua intelligenza: l’acqua che beviamo, l’aria che respiriamo e il futuro che condividiamo.